近年、「AI PC」という言葉とともに急速に普及しているNPU(Neural Processing Unit)。Intel Core UltraやAMD Ryzen AI、そしてSnapdragon X Eliteなどの登場により、ノートPCでもAI処理が可能になりつつあります。

しかし、PCゲーマーやクリエイターにとっては「GeForceなどのGPUがあれば、NPUなんていらないのでは?」という疑問がつきまとうはずです。

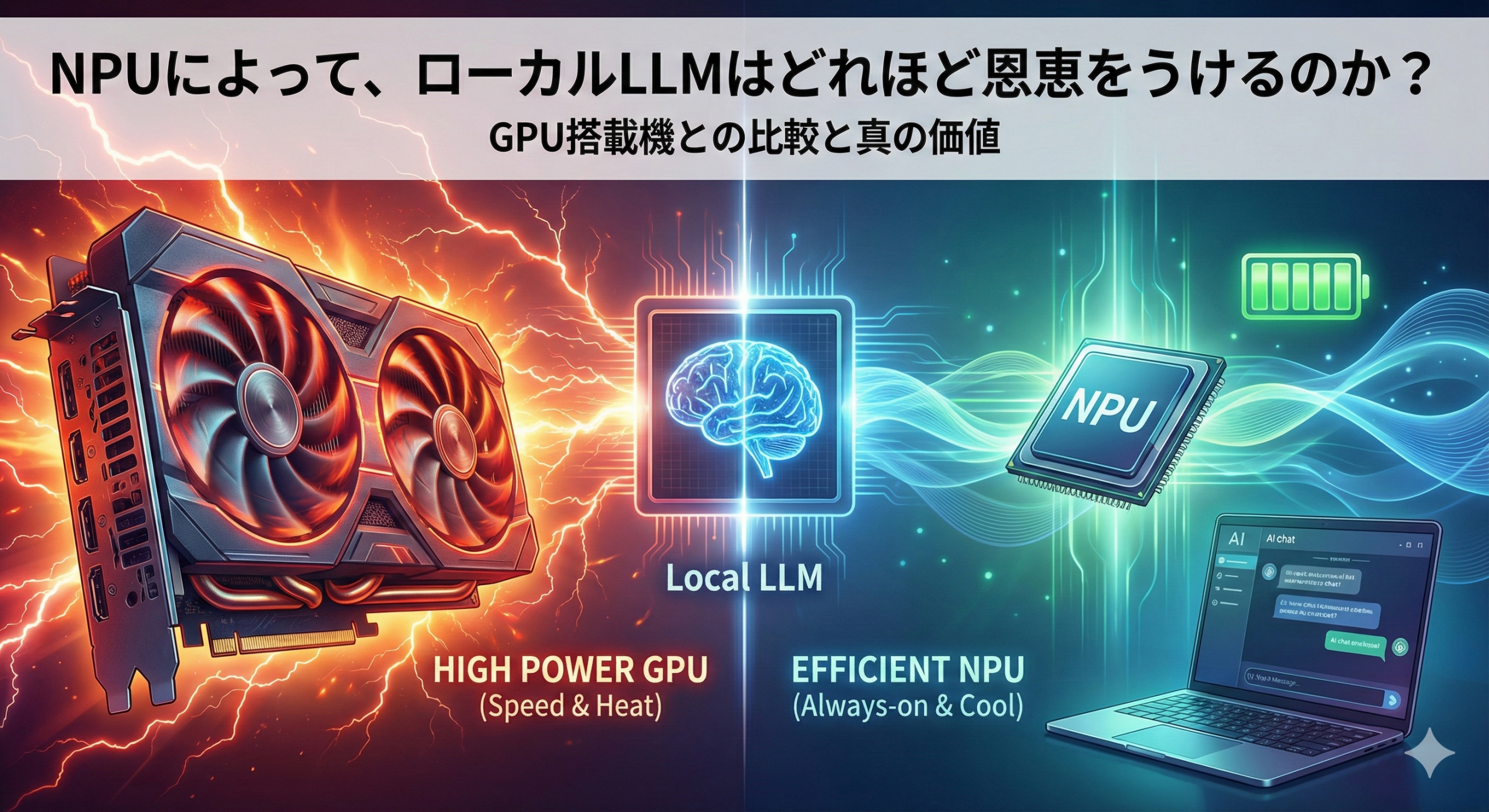

今回は、**「ローカルLLM(Llama 3やMistralなど)を動かす」**という視点に絞り、NPUがもたらす具体的な恩恵と、GPUとの使い分けについて深掘りします。

そもそもNPUとは?なぜLLMに必要なのか

NPUは、AIの計算(特に行列演算)を**「低消費電力」かつ「高効率」**に処理するために特化したプロセッサです。

- CPU: 汎用的な司令塔(器用だが、AIの大量計算は苦手)

- GPU: パワー重視の計算部隊(圧倒的に速いが、電力消費と発熱が激しい)

- NPU: AI推論専門の省エネ部隊(速度はそこそこだが、燃費が最強)

ローカルLLMにおいて、NPUは「最高速度」を出すためではなく、**「実用的な速度を、日常的な負荷で維持する」**ために存在します。

NPUによってローカルLLMが受ける「3つの恩恵」

もしあなたがNPU搭載のPCでローカルLLMを動かす場合、以下のようなメリットを体感できます。

1. 圧倒的な「ワットパフォーマンス(省電力性)」

これが最大のメリットです。GPUでLLMを動かすと、ファンが唸りを上げ、バッテリーはみるみる減っていきます。しかし、NPUは驚くほど静かです。

例えば、7B(70億パラメーター)クラスの軽量モデルであれば、NPUを使うことでバッテリー駆動のノートPCでも、数時間のチャットボット対話が可能になります。「カフェで電源なしにAIと対話しながら作業する」というシナリオでは、NPU一択です。

2. CPU・GPUリソースの「オフロード(解放)」

NPUがAI処理を担当することで、CPUとGPUがフリーになります。

- ゲーマーの場合: ゲーム(GPU負荷)をプレイしながら、裏でAIコンパニオン(NPU負荷)を動かして攻略法を聞く。

- 仕事の場合: 重いExcel処理(CPU負荷)や動画レンダリング(GPU負荷)をしながら、AIに文章要約をさせる。このように、PCの動作を重くせずにAIを常駐させることが可能になります。

3. 常時起動(Always-on)AIの実現

消費電力が低いため、OSのバックグラウンドで常に小規模なLLMを待機させておくことが現実的になります。

Copilot+ PCの「リコール機能」のように、ユーザーの操作を常にAIが解析・サポートするような使い方は、高負荷なGPUには不向きで、NPUの独壇場です。

徹底比較:NPU搭載機 vs GPU(dGPU)搭載機

では、これからPCを買うならどちらを選ぶべきでしょうか? 比較表で整理します。

| 項目 | NPU搭載機 (AI PC) | 独立GPU搭載機 (GeForce RTX等) |

| 得意なこと | 省電力での推論、バックグラウンド処理 | 圧倒的な生成速度、学習(Fine-tuning) |

| LLM生成速度 | 実用的(読める速度、10~30 tokens/s程度) | 爆速(読むのが追いつかない、50~100+ tokens/s) |

| 対応モデル | 量子化(軽量化)されたモデルが中心 | 巨大モデルや非圧縮モデルもVRAM次第で動作 |

| 消費電力・熱 | 非常に低い(ファンレスに近い運用も可) | 高い(ファンノイズと発熱は避けられない) |

| ソフトウェア | 環境構築がまだ複雑(OpenVINO, QNN等が必要) | 安定している(CUDA環境がデファクトスタンダード) |

GPU(NVIDIA GeForce等)が圧倒的に有利なケース

- 「とにかく速いレスポンスが欲しい」: ストレスフリーな会話を求めるならGPUです。

- 「ローカルで学習(LoRA作成など)もしたい」: NPUは学習には向きません。GPUが必須です。

- 「最新のモデルをすぐに試したい」: AI業界はNVIDIA中心に回っています。新しいモデルが出た際、最初にサポートされるのはGPU(CUDA)です。

NPUが有利なケース

- 「ノートPCで持ち運びながら使いたい」

- 「Web会議の要約や翻訳など、長時間回しっぱなしにしたい」

- 「ゲームや作業の邪魔をせずにAIを使いたい」

現時点での注意点:NPUは「発展途上」

NPUには大きな可能性がありますが、2024年〜2025年現在、**「ソフトウェア側の対応」**が課題です。

ローカルLLMを動かす主流ツール(LM StudioやOllamaなど)において、NPUへの最適化はまだGPUほど進んでいません。「NPUを買ったのに、設定が難しくて結局CPUで動かしている」というケースも少なくありません。

しかし、MicrosoftのDirectMLや各社のドライバアップデートにより、今後は「スイッチ一つでNPUを使う」時代が来ると予想されます。

結論:誰がNPUの恩恵を受けるのか?

- ヘビーなAI開発者・ゲーマー:迷わず GPU(NVIDIA RTX 4060以上推奨) を搭載したPCを選んでください。NPUはあくまで「補助」です。

- ビジネスマン・学生・モバイルユーザー:NPU搭載のAI PC は大きな恩恵をもたらします。バッテリーを気にせず、プライベートなローカルLLMを「自分専用のアシスタント」として常駐させることができるからです。

本記事は、Gemini Pro によって生成されました。

本画像は、Nano Banana Pro によって生成されました。