タグ: ローカルLLM

-

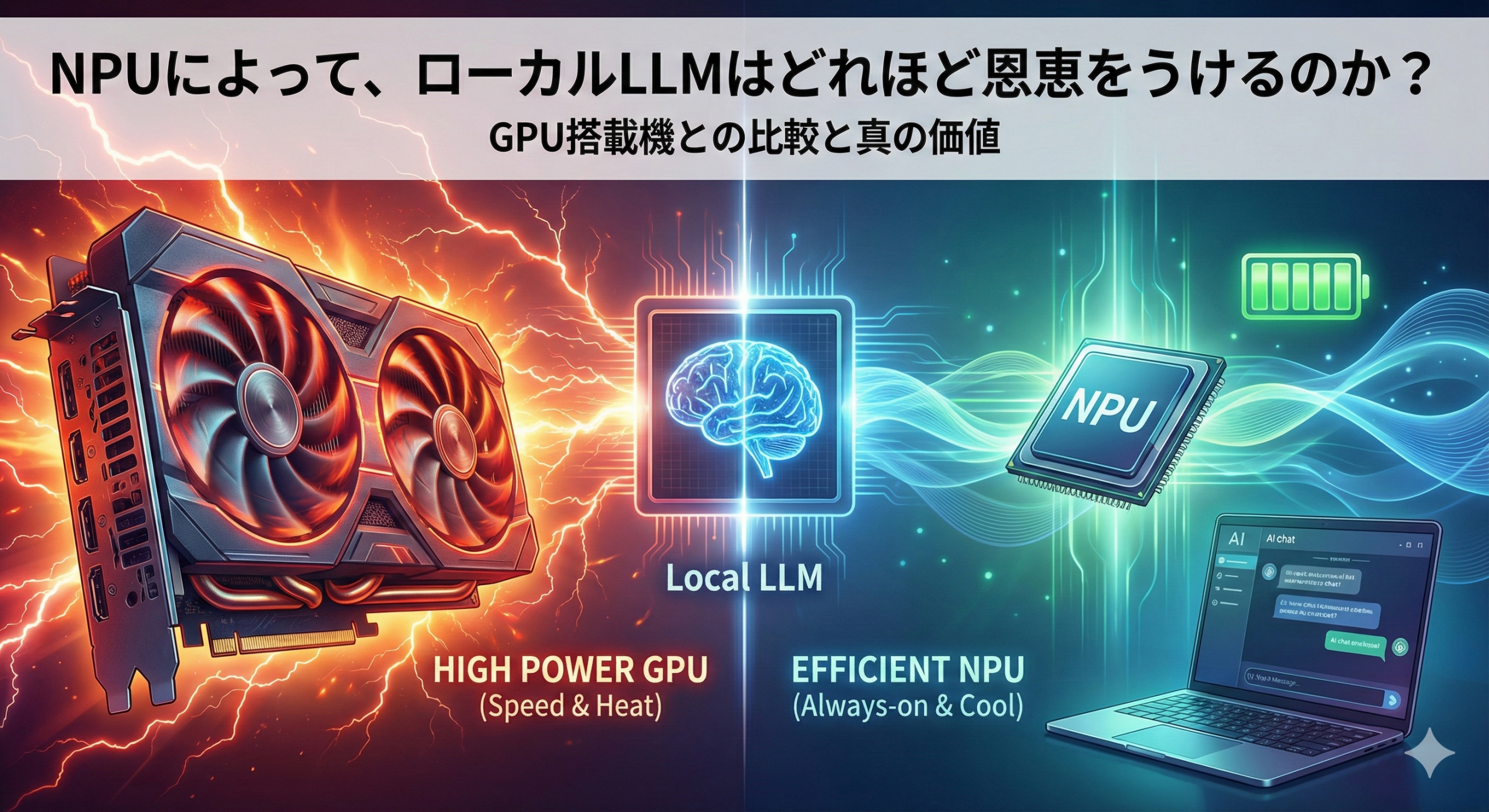

NPUはローカルLLMの救世主となるか?GPUとの決定的な違いとメリットを徹底解説

近年、「AI PC」という言葉とともに急速に普及しているNPU(Neural Processing Unit)…

-

最新のローカル環境で動く“高性能”LLM――完全ガイド(2025年版)

ローカルで「使える」高性能な大規模言語モデル(LLM)は、ここ数年で急速に進化しました。クラウドAPIに頼らず…

-

NVIDIA DGX Spark — デスクトップに収まる「個人向けAIスーパーコンピュータ」について詳しく解説

最近発表された**NVIDIA DGX Spark(通称 Spark)**は、「デスクトップで動くAIスーパー…

-

Qwen3: 次世代AIモデルの詳細解説

はじめに 2025年4月、Alibaba Cloudのチームが開発した最新の大規模言語モデル「Qwen3」がリ…

-

Apple Mac M1, M2, M3, M4 のチップ性能とLLM

序論 大規模言語モデル(LLM)は、現代の人工知能技術における最も革新的かつ変革的なイノベーションの一つとして…

-

爆速ローカルLLMをDockerで構築する方法

本日は、爆速でローカルLLMを構築する方法を解説してみたいと思います。最近、AI技術の進化に伴い、ローカルでの…